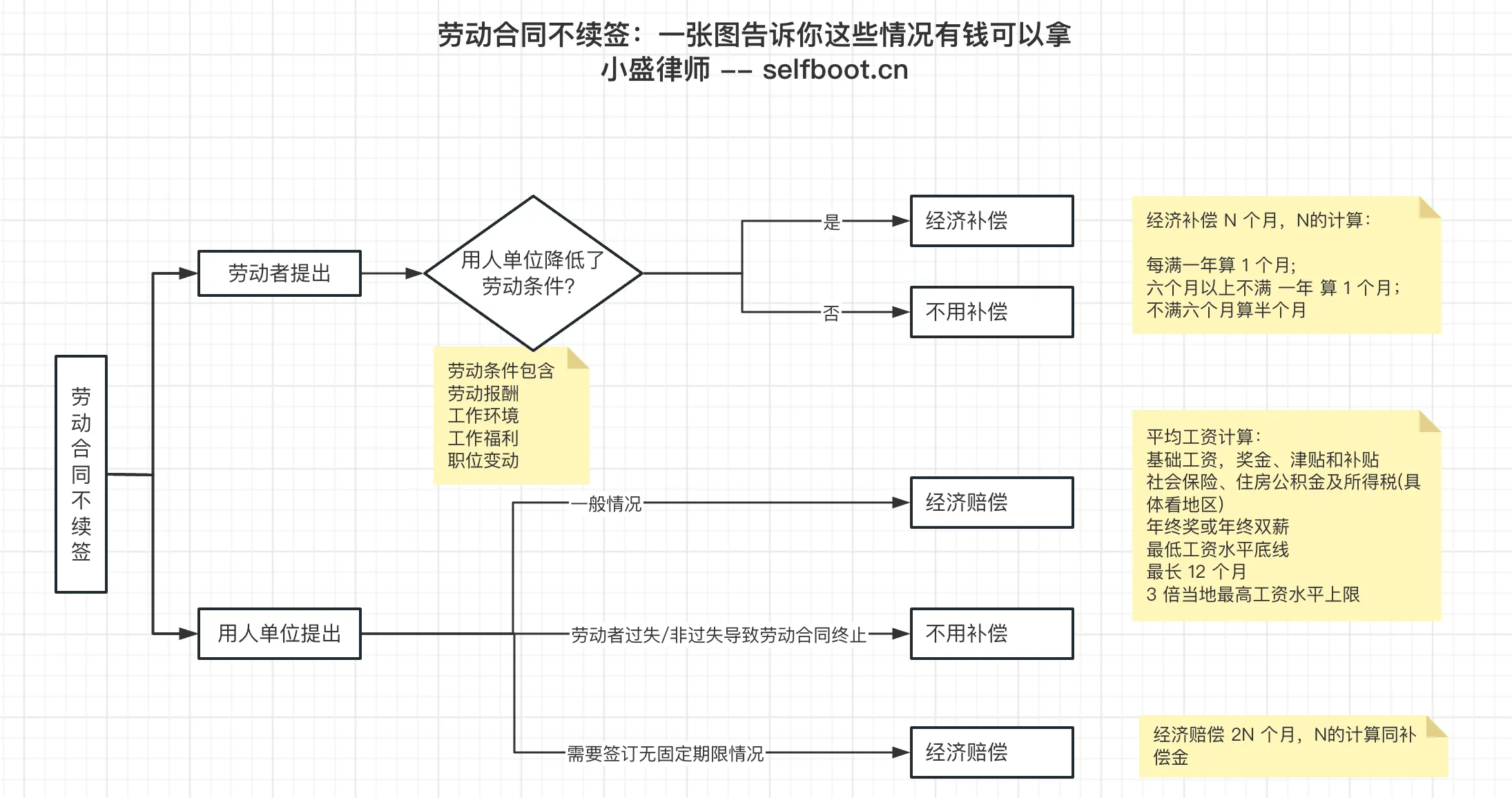

劳动合同到期不续签,一张图告诉你这些情况有钱可以拿!

每一位劳动者都会面临一个重要时刻:劳动合同是否续签?对于很多人来说,这不仅仅是工作的延续,更关乎生活的稳定和未来的规划。而用人单位方面,也需要权衡人员需求与成本控制,因此,劳动合同的续签问题往往牵涉到双方的重大利益。

然而,在实际操作中,劳动合同到期不续签可能引发一系列法律问题。劳动者和用人单位在这个过程中的权益如何保障?当不续签发生时,是否有经济补偿或赔偿金的问题?特殊情况下的法律保护又是如何规定的?

接下来,我将深入探讨劳动合同到期不续签的法律视角,逐一解析劳动者不续签、用人单位不续签的经济补偿、赔偿金,以及一些特殊情况下的法律保护等问题,并通过实际案例分析,让这些法律条文更贴近生活,帮助大家更好地维护自身的合法权益。