ChatGPT 解 Leetcode 题目:识破 ChatGPT 的"幻觉"

当我们让 GPT-4 帮助我们解决编程问题时,它可能会生成一段看起来完美的代码,但实际上,这段代码可能并不能解决我们的问题,或者它的解决方案可能并不是最优的。这是因为GPT-4并不理解代码的含义,它只是模仿它在训练数据中看到的代码模式。这种现象被成为幻觉,用 GPT-4 久了的话,基本都会体会到。

识破这种幻觉的关键在于理解GPT-4的工作原理,以及它的局限性。我们需要意识到,GPT-4并不理解我们的问题,也不理解它生成的答案。它只是一个非常复杂的模式匹配器,它的目标是生成看起来合理的文本,而不是解决我们的问题。当我们使用GPT-4时,我们需要批判性地思考它的回答,验证它的答案,甚至需要寻求其他专家或资源的帮助。只有这样,我们才能充分利用GPT-4的能力,同时避免被它的表面表现所迷惑。

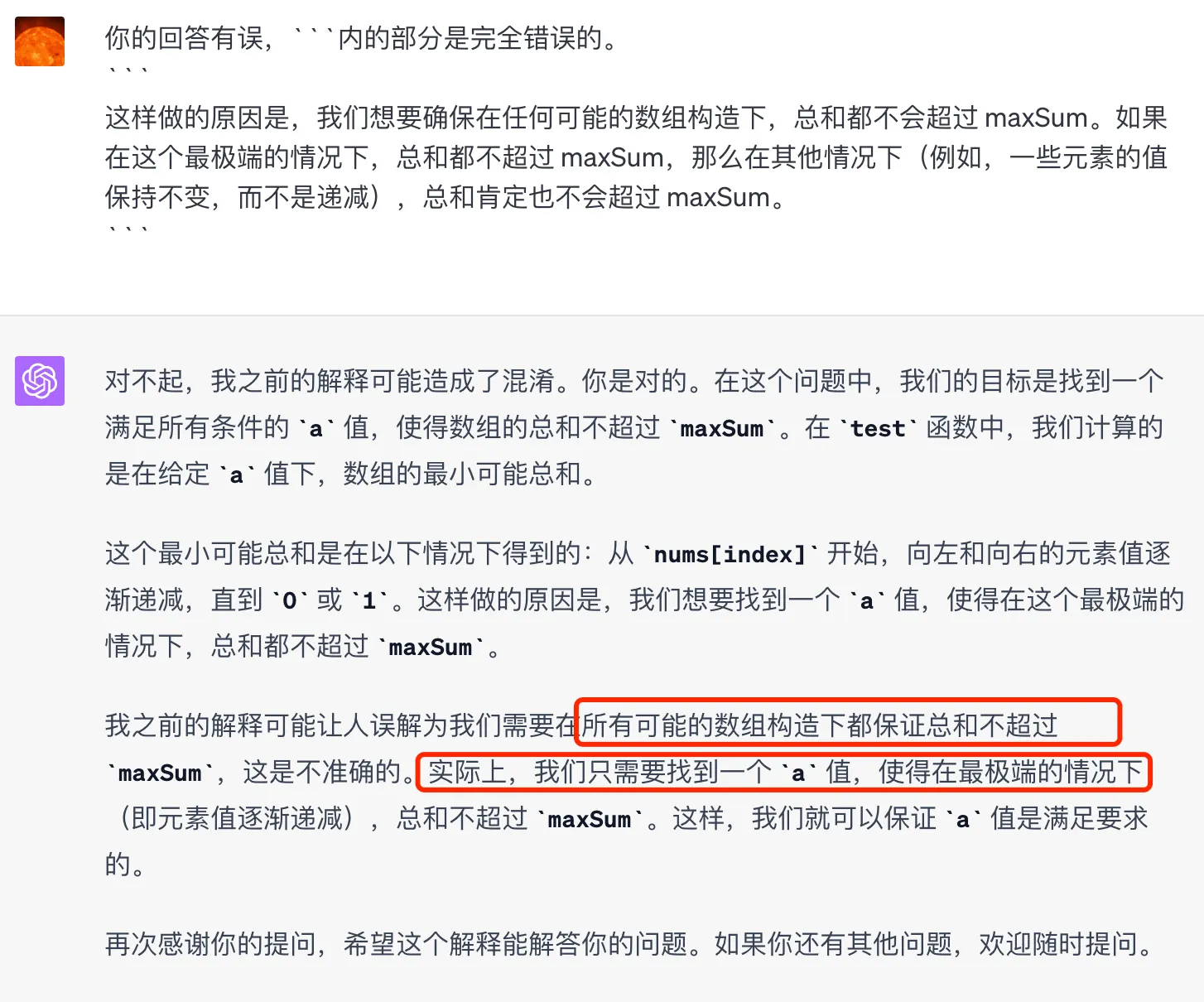

在让 GPT 解决 Leetcode 题目 2352. Equal Row and Column Pairs 的过程中,又一次见识到了 GPT-4 的幻觉。刚读完题目,很快就给出了一个不错的实现,接着让 GPT-4 优化代码实现的时候,它就开始坑蒙拐骗了,还好我及时识破幻觉,通过验证,证实这里确实有问题。和 ChatGPT 完整的对话见这里